大数据培训_机器学习模型的评价指标和方法

衡量分类器的好坏

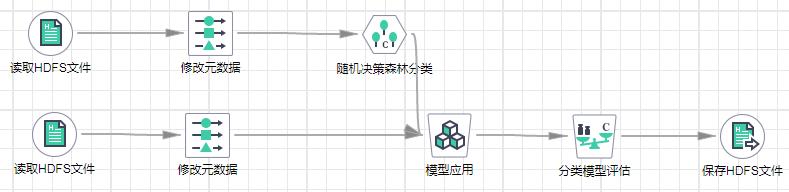

分类模型评估用于对分类模型的预测结果进行评估,分别可以对二分类模型和多分类模型进行评估,具体由目标变量的类别数来确定。

对于二分类模型,评估指标包括:混淆矩阵(Confusion Matrix)、精确率(Precision)、召回率(Recall)、F1值(F1-Measure)、AUC、ROC曲线(Receiver Operating Characteristic)、PR曲线(Precision and Recall)。

对于多分类模型,评估指标包括混淆矩阵(Confusion Matrix)、准确率(Accuracy)、各类别精准率(Precision by Label)、各类别召回率(Recall by Label)、各类别F1值(F1-Measure by Label)。

二分类问题

对于二分类问题,要求将实际样本分成正样本(positive)或负样本(negative),则预测结果会出现以下四种情况:

二分类问题的预测结果

实际 | 预测 | 结果 |

正样本 | 正样本 | 真正样本(TP) |

负样本 | 正样本 | 假正样本(FP) |

负样本 | 负样本 | 真负样本(TN) |

正样本 | 负样本 | 假负样本(FN) |

例如下述场景:某班有60名男生,40名女生,共100人。目标要找出所有的女生。现在某人挑选出了50人,其中有35名女生,15名男生,则:

真正样本(TP):35(预测正确的女生)

假正样本(FP):15(误当女生预测的男生)

真负样本(TN):45(预测正确的男生)

假负样本(FN):5(误当男生预测的女生)

可得到以下标量来评估这次的分类工作:

精确率:Precision=TP/(TP+FP)

召回率:Recall=True Positive Rate(TPR)=TP/(TP+FN)

F1测量:F1-Measure=2TP/(2TP+FP+FN)

FPR:False Positive Rate(FPR)=FP/(FP+TN)

PR曲线:以Precision为y轴,Recall为x轴绘制得到的曲线。

ROC曲线:以TPR为y轴,FPR为x轴绘制得到的曲线。

AUC数据:ROC曲线下方的面积值。

要计算这些指标,模型评估输入数据集中需要包含Target列,该列数据元数据的第二个Nominal值代表正样本。

对于多分类问题,根据多个类别的预测结果构建混淆矩阵,每一列代表预测值,每一行代表实际的类别。

准确率(Accuracy)是指全局预测正确的样本数占所有样本数的比例。

各类别精准率(Precision by Label)是指在该类别中预测正确样本数占预测为该类别样本数的比例。

各类别召回率(Recall by Label)是指在该类别中预测正确的样本数占该类别实际样本数的比例。

各类别F1值(F1-Measure by Label)是根据各类别精准率和召回率计算得到的评价指标。

评判标准

AUC表示为ROC曲线下方的面积,简单来说,AUC值越大,说明模型分类正确率

越高。

准确率表示样本中被识别成正样本准确率,即正样本被识别成正样本的个数与所

有样本被识别成正样本个数比例,衡量模型的查准率,数值越高越好。

召回率表示样本中正样本被识别成正样本的比例,即被识别成正样本的个数与实

际正样本的个数比例,衡量模型的查全率,数值越高越好。

F1 score是统计学中用来衡量二分类模型精确度的一种指标。可以看作是模型准确

率和召回率的一种加权平均,数值越高越好。